L’IA accélère le processus militaire du Pentagone

Alors que l'intelligence artificielle (IA) s'immisce dans tous les domaines, le secteur de la défense n'y échappe pas. Les géants de la tech comme OpenAI et Anthropic se retrouvent face à un défi de taille : fournir au Pentagone des outils pour gagner en efficacité, sans pour autant franchir la ligne rouge de la létalité autonome.

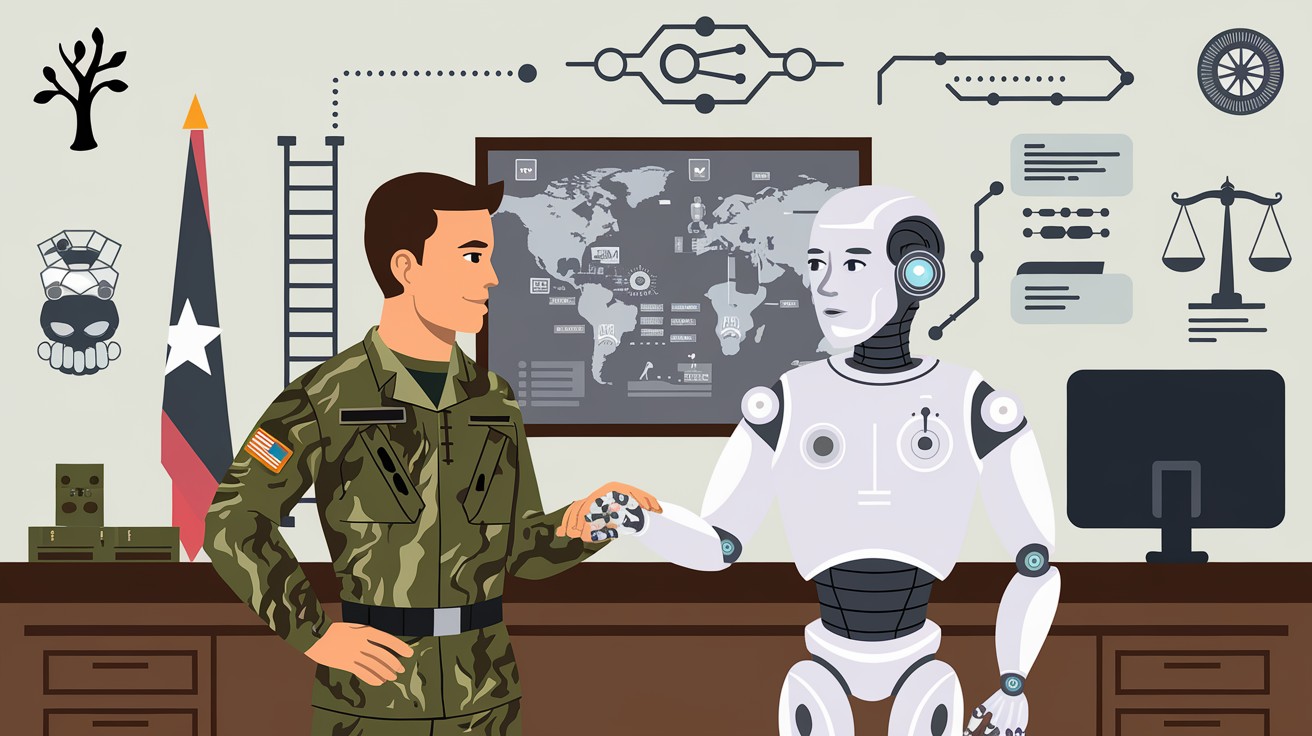

Une IA au service de la chaîne de commandement

Si les systèmes d'IA ne sont pas utilisés directement comme armes, ils confèrent néanmoins un "avantage significatif" au Département de la Défense américain selon les dires de sa directrice du numérique et de l'IA, Radha Plumb. L'IA permet en effet d'identifier, suivre et évaluer les menaces de manière bien plus rapide et précise qu'un opérateur humain.

"Nous augmentons clairement les moyens d'accélérer l'exécution de la chaîne de commandement afin que nos décideurs puissent réagir au bon moment pour protéger nos forces", explique Radha Plumb.

– Dr. Radha Plumb, Directrice du numérique et de l'IA du Pentagone

Cette fameuse "kill chain", ou boucle décisionnelle menant à la neutralisation d'une cible, implique un système complexe de capteurs, de plateformes et d'armements. L'IA générative s'avère particulièrement utile lors des phases de planification et d'élaboration de stratégies.

Les géants de la tech entrent dans la danse

Depuis 2024, des acteurs majeurs comme OpenAI, Anthropic et Meta ont adapté leurs politiques d'utilisation pour permettre aux agences de renseignement et de défense américaines d'exploiter leurs systèmes d'IA, tout en maintenant l'interdiction d'utiliser leurs technologies pour nuire à des êtres humains. Une position d'équilibriste qui a ouvert la voie à une série de partenariats :

- Meta avec Lockheed Martin et Booz Allen pour déployer ses modèles Llama auprès du Pentagone.

- Anthropic main dans la main avec Palantir.

- OpenAI associé à Anduril.

- Cohere collaborant discrètement avec Palantir.

Au fur et à mesure que l'IA générative prouve son utilité au sein du Pentagone, la Silicon Valley pourrait être tentée d'assouplir davantage ses règles en matière d'applications militaires.

L'humain garde la main sur les décisions de vie ou de mort

Un débat agite actuellement le monde de la défense : faut-il autoriser des armes à IA à prendre des décisions de vie ou de mort de manière autonome ? Certains affirment que l'armée américaine dispose déjà de tels systèmes. Une affirmation réfutée par le Pentagone qui assure qu'un opérateur humain reste toujours dans la boucle.

"Par souci de fiabilité et d'éthique, nous impliquerons toujours des êtres humains dans la décision d'employer la force, y compris pour nos systèmes d'armes".

– Dr. Radha Plumb

Selon la responsable, la collaboration entre humains et machines au sein du Pentagone ne ressemble en rien aux versions science-fiction d'IA décidant seules du sort de vies humaines. La réalité serait plus nuancée, avec des décideurs de haut niveau impliqués activement à chaque étape du processus.

Vers une IA militaire fiable et éthique

Au-delà de l'enjeu d'efficacité opérationnelle, c'est bien la question de la fiabilité et de l'éthique des systèmes d'IA militaires qui est posée. Pour certains chercheurs comme Evan Hubinger d'Anthropic, collaborer directement avec l'armée est indispensable pour s'assurer que ces technologies soient développées et utilisées de manière responsable.

L'avenir nous dira si cet équilibre entre le besoin d'efficacité du Pentagone et les garde-fous éthiques posés par la Silicon Valley est tenable sur le long terme. Une chose est sûre : l'intégration de l'IA dans la sphère militaire ne fait que commencer et promet de profonds bouleversements dans l'art de la guerre. Reste à s'assurer que l'humain garde bien la main sur les décisions les plus critiques.