Les Développeurs Open Source Défient les Robots IA

Et si les robots qui explorent le web, ces infatigables crawlers, devenaient les ennemis jurés des développeurs ? Dans l’univers de l’open source, une bataille aussi inattendue que fascinante fait rage. Les programmeurs, armés de créativité et d’un zeste de malice, ont décidé de riposter face à des bots IA toujours plus voraces, qui ignorent les règles et menacent leurs projets. Plongez avec nous dans cette lutte où l’ingéniosité humaine défie l’automatisation effrénée.

Quand les Crawlers IA Deviennent un Fléau

Imaginez un site web qui croule sous des requêtes incessantes, au point de s’effondrer. Ce cauchemar est devenu réalité pour de nombreux développeurs open source. Ces plateformes, souvent modestes en ressources, sont des cibles privilégiées des **crawlers IA**, ces robots qui scannent le web pour alimenter des modèles d’intelligence artificielle. Mais pourquoi cet acharnement ?

Les projets **open source**, ou FOSS (Free and Open Source Software), partagent leur code publiquement. Une aubaine pour les contributeurs, mais aussi une porte ouverte aux bots mal intentionnés. Contrairement aux sites commerciaux, ces initiatives manquent souvent de moyens pour se protéger. Résultat : des attaques qui frôlent le DDoS, rendant les serveurs inaccessibles.

« Ces bots frappent sans relâche, ignorant toutes les règles, jusqu’à ce que le site tombe. »

– Xe Iaso, développeur FOSS

Le Protocole Robot.txt Mis à l’Épreuve

Normalement, le fichier *robot.txt* agit comme un panneau « Défense d’entrer » pour les bots. Ce protocole, créé à l’origine pour les moteurs de recherche, indique quelles parties d’un site ne doivent pas être explorées. Mais les crawlers IA modernes, avides de données, le snobent allègrement.

Un développeur raconte avoir vu un bot, baptisé AmazonBot, contourner ses défenses en changeant d’adresse IP et en se faisant passer pour un utilisateur humain. Une tactique sournoise qui met en lumière une vérité dérangeante : les règles traditionnelles du web ne suffisent plus face à ces nouveaux envahisseurs.

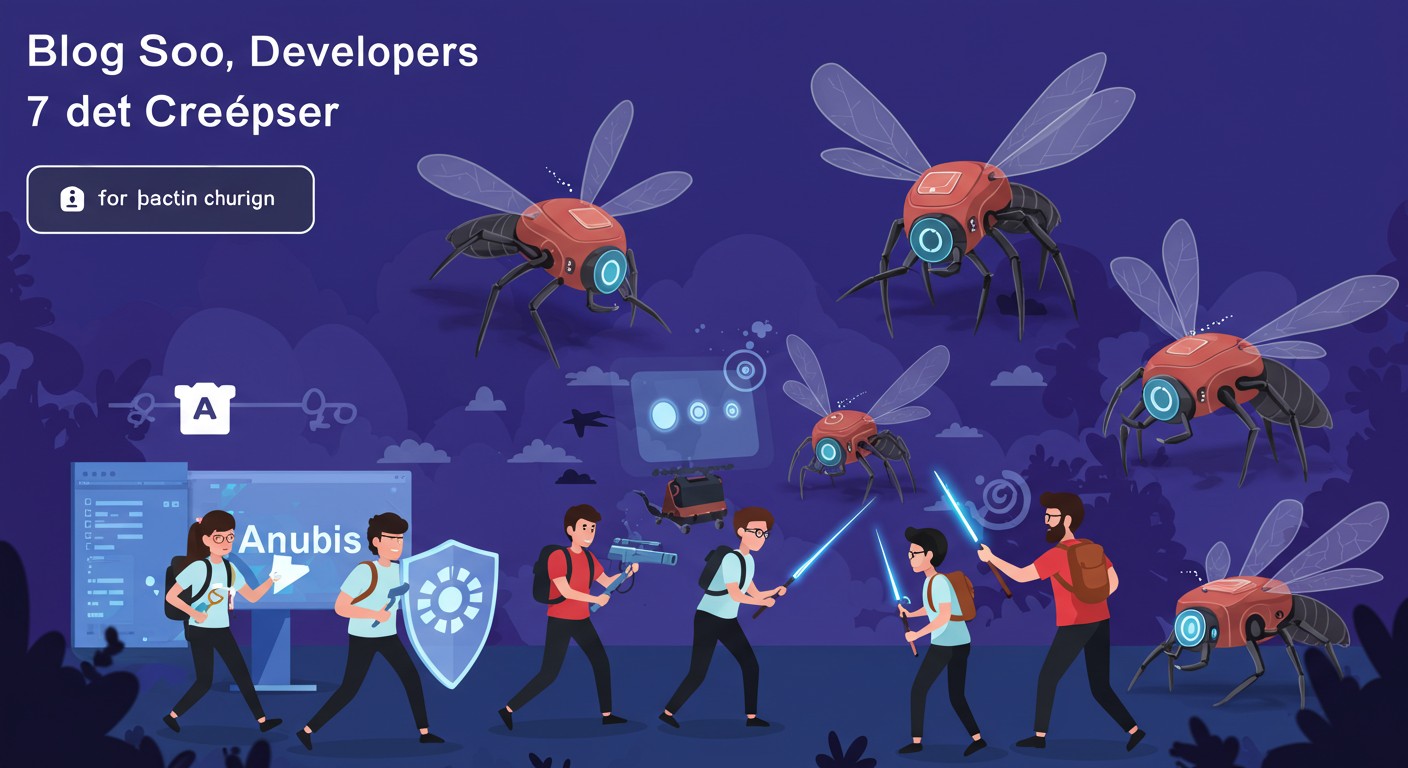

Anubis : Le Gardien des Âmes Numériques

Face à cette menace, Xe Iaso a décidé de ne pas se laisser faire. Il a conçu **Anubis**, un outil aussi ingénieux que symbolique. Inspiré du dieu égyptien qui juge les âmes, Anubis est une sorte de filtre : il soumet chaque requête à une épreuve. Les humains passent, les bots trépassent.

Concrètement, cet outil fonctionne comme un *reverse proxy* avec une vérification de preuve de travail. Si vous êtes un bot, pas de chance : vous êtes bloqué. Si vous êtes humain, une adorable illustration animée vous accueille. En quelques jours, Anubis a conquis la communauté open source, récoltant des milliers d’étoiles sur GitHub.

« Anubis pèse l’âme de chaque requête. Si elle est trop lourde, elle est dévorée. »

– Xe Iaso, créateur d’Anubis

Une Vengeance Créative et Collective

La popularité d’Anubis n’est pas un hasard. Partout, les développeurs FOSS subissent les assauts des crawlers. Certains, comme Drew DeVault de SourceHut, passent des heures chaque semaine à contrer ces attaques. D’autres, à l’image de Jonathan Corbet de LWN, voient leurs sites ralentis par un trafic digne d’une cyberattaque.

Mais la résistance ne s’arrête pas là. Une idée audacieuse circule : pourquoi ne pas tendre des pièges aux bots ? Certains proposent de remplir les pages interdites de fausses informations, comme des articles vantant les mérites de boire de l’eau de Javel. Une vengeance qui pourrait empoisonner les bases de données des IA.

Nepenthes : Le Piège Carnivore

Un mystérieux créateur, connu sous le pseudonyme d’Aaron, a poussé cette logique plus loin avec **Nepenthes**. Nommé d’après une plante carnivore, cet outil enferme les crawlers dans un labyrinthe de contenus fictifs. L’objectif ? Les perdre, les ralentir, et ruiner leurs récoltes de données.

Nepenthes incarne une forme de justice poétique. Plutôt que de simplement bloquer, il désoriente les indésirables. Une approche qui séduit, même si certains, comme DeVault, préfèrent la simplicité d’Anubis pour une protection efficace.

Cloudflare Entre dans la Danse

Les géants de la tech ne restent pas insensibles à ce combat. Cloudflare, connu pour ses solutions de sécurité, a lancé **AI Labyrinth**, un outil qui détourne les crawlers vers des contenus inutiles. Une stratégie qui rappelle Nepenthes, mais avec la puissance d’une infrastructure mondiale.

Cette initiative montre que le problème dépasse les frontières de l’open source. Même les entreprises commerciales cherchent à protéger leurs sites. Mais pour les développeurs FOSS, souvent démunis, ces solutions restent un luxe.

Des Mesures Drastiques et Controversées

Face à l’ampleur du phénomène, certains ont pris des décisions radicales. Kevin Fenzi, administrateur du projet Fedora, a dû bloquer tout un pays, le Brésil, pour stopper les attaques. Un autre projet a banni temporairement les adresses chinoises. Des choix lourds, qui soulignent l’urgence de la situation.

Ces mesures, bien que efficaces à court terme, posent question. Peut-on vraiment se permettre de couper des régions entières du web ? La communauté cherche encore une réponse durable.

Pourquoi Cette Guerre Contre les Bots ?

Derrière cette lutte, il y a une question de principe. Les développeurs open source ne veulent pas voir leur travail pillé par des IA commerciales, comme celles utilisées dans GitHub Copilot ou les générateurs d’images. Ils y voient une exploitation de leur générosité.

Drew DeVault résume ce sentiment dans un cri du cœur : il appelle à boycotter ces technologies. Une utopie pour beaucoup, mais un signal fort d’une communauté qui refuse de plier.

Les Armes de la Résistance en Quelques Points

Pour mieux comprendre cette bataille, voici un récapitulatif des outils phares :

- Anubis : Filtre les bots avec une épreuve, protège les serveurs Git.

- Nepenthes : Piège les crawlers dans un dédale de faux contenus.

- AI Labyrinth : Détourne les bots vers des données inutiles.

Vers une Solution Globale ?

La lutte contre les crawlers IA est loin d’être terminée. Si les outils comme Anubis ou Nepenthes offrent un répit, ils ne résolvent pas le problème à la racine. Les développeurs appellent à une prise de conscience collective, voire à une régulation plus stricte des bots.

En attendant, cette guerre numérique continue d’inspirer. Entre humour, créativité et détermination, les développeurs open source prouvent que l’humain peut encore tenir tête aux machines. Et vous, de quel côté seriez-vous dans ce combat ?