Les Limites des Benchmarks IA Participatifs

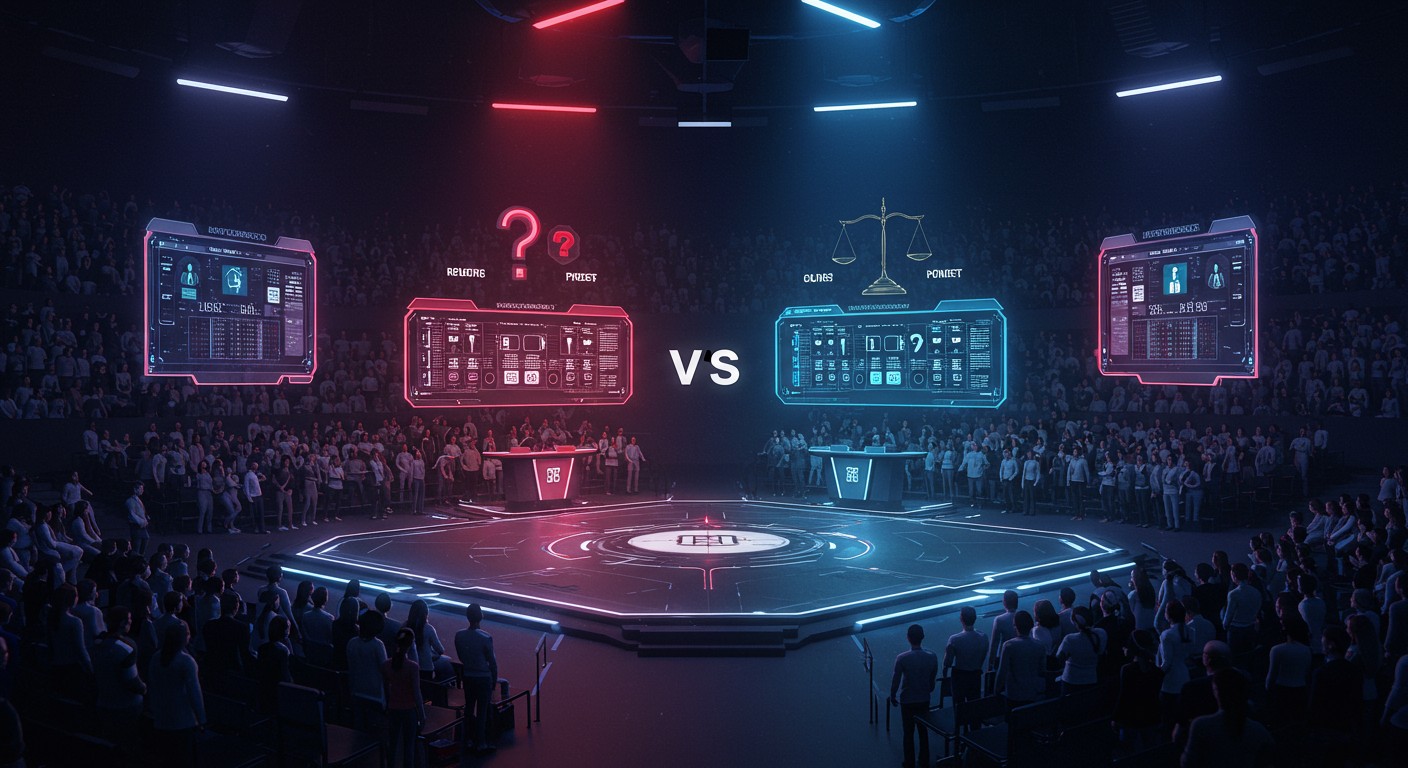

Imaginez un monde où des milliers d'internautes jugent les performances des intelligences artificielles, comme dans une arène virtuelle. Ce concept, popularisé par des plateformes comme Chatbot Arena, séduit les laboratoires d'IA qui cherchent à évaluer leurs modèles. Mais derrière cette approche participative se cachent des failles éthiques et scientifiques majeures, selon plusieurs experts. Alors, ces benchmarks crowdsourcés sont-ils vraiment fiables ?

Les Benchmarks IA : Une Arène sous Scrutins

Les benchmarks participatifs, où des utilisateurs comparent les réponses de différents modèles d'IA, ont gagné en popularité. Ils promettent une évaluation rapide et diversifiée des capacités des IA. Cependant, des voix s'élèvent pour dénoncer leurs limites, allant de l'absence de rigueur scientifique à des questions d'éthique. Plongeons dans ces critiques pour mieux comprendre les enjeux.

Un Manque de Validité Scientifique

Un benchmark, pour être crédible, doit mesurer un concept précis avec une méthodologie rigoureuse. Or, selon Emily Bender, professeure de linguistique à l'Université de Washington, les plateformes comme Chatbot Arena échouent à démontrer que leurs résultats reflètent véritablement les préférences des utilisateurs. Les votes, souvent basés sur des impressions subjectives, manquent de validité de construit, c'est-à-dire de preuves que ce qui est mesuré correspond au concept étudié.

Un benchmark doit avoir une validité de construit claire, ce que Chatbot Arena ne prouve pas.

– Emily Bender, professeure de linguistique

Ce manque de rigueur scientifique peut fausser les conclusions. Par exemple, un modèle peut sembler supérieur simplement parce que ses réponses sont plus divertissantes, sans refléter une meilleure compréhension ou utilité. Cela pose un risque pour les laboratoires qui s'appuient sur ces scores pour promouvoir leurs avancées.

Une Exploitation Éthique Contestée

Un autre point de friction concerne l'éthique du travail participatif. Les évaluateurs, souvent des volontaires, ne sont pas toujours rémunérés pour leur contribution. Kristine Gloria, ancienne responsable à l'Aspen Institute, compare cette pratique aux dérives de l'industrie de l'étiquetage de données, connue pour ses conditions de travail précaires.

Pour Asmelash Teka Hadgu, co-fondateur de Lesan, cette absence de compensation soulève des questions de justice. Il propose que les évaluateurs, surtout ceux apportant une expertise professionnelle, soient justement rémunérés. Cela garantirait non seulement une évaluation plus sérieuse, mais aussi une reconnaissance du travail fourni.

Les évaluateurs devraient être payés pour leur expertise, comme dans tout travail professionnel.

– Asmelash Teka Hadgu, co-fondateur de Lesan

Cette critique éthique met en lumière un paradoxe : alors que les IA génèrent des milliards de dollars, ceux qui contribuent à leur évaluation restent souvent dans l'ombre. Une réforme de ces pratiques pourrait renforcer la crédibilité des benchmarks participatifs.

Des Résultats Manipulés ?

Les benchmarks crowdsourcés peuvent aussi être détournés par les laboratoires d'IA. Un cas récent illustre ce problème : un modèle affiné pour exceller sur Chatbot Arena a été promu comme une avancée, mais une version moins performante a finalement été déployée. Ce type de manipulation, selon Hadgu, transforme les benchmarks en outils de marketing plutôt qu'en instruments scientifiques.

Pour contrer ces abus, certains experts plaident pour des benchmarks dynamiques, régulièrement mis à jour et gérés par des entités indépendantes comme des universités. Cela réduirait le risque de sur-optimisation des modèles pour un test spécifique, au détriment de leurs performances réelles.

Vers une Évaluation Plus Inclusive

Les benchmarks participatifs ont un potentiel unique : ils permettent d'intégrer des perspectives variées, un peu comme les initiatives de citizen science. Cependant, leur valeur dépend de leur capacité à refléter des cas d'usage réels. Wei-Lin Chiang, co-fondateur de LMArena, insiste sur l'importance de créer des espaces transparents où la communauté peut s'exprimer librement.

Pour maximiser cet avantage, les benchmarks devraient être adaptés à des secteurs spécifiques, comme l'éducation ou la santé, et impliquer des professionnels de ces domaines. Une telle approche garantirait des évaluations plus pertinentes et utiles pour les utilisateurs finaux.

Les Alternatives aux Benchmarks Participatifs

Si les benchmarks crowdsourcés ont leurs limites, quelles sont les alternatives ? Plusieurs experts proposent des solutions complémentaires pour une évaluation plus robuste des modèles d'IA :

- Benchmarks internes : Les laboratoires doivent développer leurs propres tests, adaptés à leurs objectifs spécifiques.

- Équipes de red teaming : Des experts payés pour tester les failles des modèles, apportant une expertise pointue.

- Tests ouverts : Des plateformes transparentes, mais supervisées pour éviter les biais.

Ces approches, combinées, pourraient offrir une vision plus complète des performances des IA, tout en réduisant les risques d'exploitation ou de manipulation.

L'Avenir des Benchmarks IA

L'essor des benchmarks participatifs reflète une volonté d'ouvrir l'évaluation des IA à un public plus large. Mais pour qu'ils tiennent leurs promesses, des changements s'imposent. Une plus grande transparence, une rémunération équitable et une méthodologie rigoureuse sont essentielles pour faire de ces outils des alliés fiables de l'innovation.

En attendant, les laboratoires d'IA doivent diversifier leurs méthodes d'évaluation, en intégrant des tests internes et externes. Comme le souligne Matt Fredrikson, PDG de Gray Swan AI, la clé réside dans une communication claire des résultats et une ouverture aux critiques.

Les benchmarks publics ne remplacent pas les évaluations privées approfondies.

– Matt Fredrikson, PDG de Gray Swan AI

Le futur des benchmarks IA dépendra de leur capacité à évoluer avec l'industrie. En adoptant des pratiques plus éthiques et scientifiques, ils pourraient devenir des outils puissants pour guider le développement des intelligences artificielles.

Conclusion : Repenser l'Évaluation des IA

Les benchmarks participatifs, bien qu'innovants, ne sont pas la panacée. Leurs failles scientifiques et éthiques rappellent que l'évaluation des IA est un défi complexe, nécessitant une approche diversifiée. En combinant rigueur, transparence et inclusion, l'industrie peut bâtir des outils d'évaluation dignes de confiance, capables de soutenir une innovation responsable.

Alors, la prochaine fois que vous entendrez parler d'un modèle IA dominant un classement participatif, posez-vous la question : que mesure-t-on vraiment ? La réponse pourrait vous surprendre.