Data centers : comment l’IA force une révolution énergétique

L'explosion de l'intelligence artificielle générative a pris tout le monde de court. En quelques mois seulement, la demande en capacité de calcul a dépassé ce qu'on anticipait pour 2030. Les data centers, ces infrastructures qu'on ne voit jamais mais qui font tourner notre quotidien numérique, se retrouvent coincés entre trois feux : les tensions géopolitiques, l'urgence climatique et la course technologique. On ne se demande plus si on en a besoin - évidemment qu'on en a besoin - mais plutôt comment éviter la catastrophe énergétique tout en continuant d'innover.

Quand l'IA générative affole les compteurs

ChatGPT, Midjourney, Claude, Gemini... Ces noms qu'on utilise tous les jours cachent une réalité peu ragoutante. À chaque fois que vous posez une question à un modèle d'IA, vous consommez dix fois plus d'énergie qu'avec une recherche Google classique. Multipliez ça par plus de 100 millions d'utilisateurs quotidiens, et vous comprenez pourquoi les infrastructures sont sous pression. Microsoft a d'ailleurs récemment avoué que ses émissions carbone avaient grimpé de 30% rien qu'à cause de ses investissements dans l'IA. Plutôt embarrassant quand on prétend viser la neutralité carbone.

Cette course technologique rebat complètement les cartes au niveau mondial. La France tire son épingle du jeu grâce au nucléaire - un atout énorme quand on cherche de l'électricité bas-carbone en quantité. Le marché du data center en France explose littéralement, avec plusieurs projets pharaoniques annoncés pour 2026. Les acteurs se battent pour dénicher les emplacements parfaits : beaucoup d'électricité disponible, connexions réseau ultra-rapides, et si possible un climat tempéré pour limiter les besoins en refroidissement.

Le dilemme énergétique européen

L'Europe s'est mise dans une situation intenable. Les data centers engloutissent maintenant près de 4,5% de la consommation électrique du continent. Et l'Agence Internationale de l'Énergie prévoit que ce chiffre pourrait doubler d'ici 2028. Le problème ? On est en pleine transition vers les renouvelables, et ça crée une intermittence qui ne fait pas bon ménage avec des installations qui doivent tourner 24h/24. L'Irlande est même allée jusqu'à geler l'autorisation de nouveaux projets - leur réseau n'en peut plus.

Face à ça, les opérateurs rivalisent de créativité. Le refroidissement par immersion gagne du terrain : on plonge carrément les serveurs dans des bains de fluides spéciaux, et la chaleur s'évacue avec une efficacité 20 fois supérieure à l'air classique. Microsoft pousse le concept encore plus loin en testant des data centers sous-marins au large de l'Écosse. L'idée ? Utiliser l'eau froide de l'océan comme système de refroidissement gratuit et illimité. Audacieux, mais pas sans risques.

Souveraineté numérique : la bataille invisible

La France durcit ses positions sur la protection des données stratégiques. Entre le règlement RGPD qui impose des standards stricts de traitement des données personnelles et la doctrine du Cloud de confiance portée par l'ANSSI, les acteurs français du numérique bénéficient d'un cadre réglementaire de plus en plus favorable. Les hébergeurs de données de santé (HDS) doivent désormais répondre à des certifications spécifiques, et les données sensibles des administrations publiques sont progressivement rapatriées sur des infrastructures nationales.

Cette dynamique profite particulièrement aux acteurs français tels UltraEdge qui proposent des alternatives crédibles aux hyperscalers internationaux. Des consortiums nationaux émergent, notamment autour du projet Gaia-X qui cherche à fédérer les acteurs européens du cloud. Pour les administrations publiques et les secteurs stratégiques comme la santé ou la défense, le choix d'un prestataire français devient un critère décisif. Cette réindustrialisation numérique fait émerger tout un écosystème local de data centers conçus selon les standards français et européens de protection des données.

"Celui qui contrôle les infrastructures numériques contrôle l'économie du XXIe siècle"

– Thierry Breton, ancien Commissaire européen au Marché intérieur, mars 2025

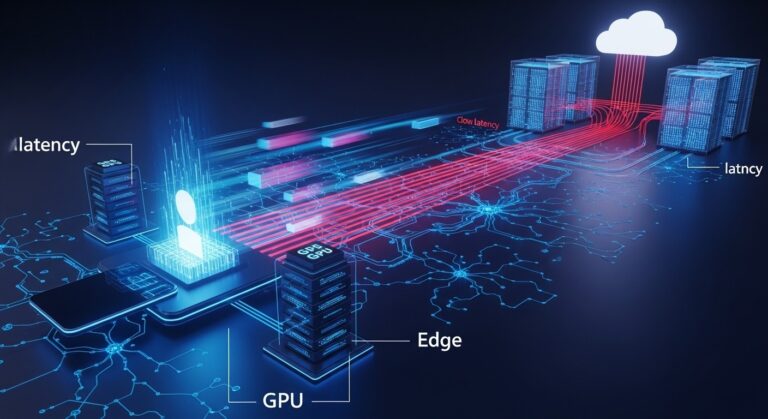

L'edge computing arrive à maturité

La 5G (et bientôt la 6G) change complètement la donne. Au lieu d'envoyer toutes les données vers des centres distants, l'edge computing traite l'information directement là où elle est générée. C'est important pour les véhicules autonomes par exemple - une voiture ne peut pas se permettre d'attendre qu'un serveur à 200 kilomètres valide une décision de freinage d'urgence. Chaque milliseconde compte.

Les opérateurs télécom déploient donc des micro-data centers au pied des antennes 5G. Ces installations compactes, parfois de la taille d'un frigo, apportent la puissance de calcul là où on en a besoin. L'industrie manufacturière adopte massivement ce modèle : les usines intelligentes analysent en temps réel les données de milliers de capteurs sans saturer les connexions vers le cloud central.

Quand l'IA optimise l'IA

Ironie du sort : l'intelligence artificielle devient aussi la solution au problème qu'elle aggrave. Les algorithmes de Machine Learning gèrent maintenant l'ensemble des paramètres opérationnels - température optimale, répartition dynamique des charges, prédiction des pannes. Google affirme avoir réduit sa consommation de refroidissement de 40% grâce au Machine Learning qui ajuste en permanence des milliers de variables.

Les serveurs eux-mêmes évoluent vers des architectures spécialisées. Les puces GPU classiques, conçues au départ pour les jeux vidéo, cèdent progressivement la place à des processeurs dédiés exclusivement à l'IA. Ces TPU (Tensor Processing Units) ou NPU (Neural Processing Units) exécutent les calculs d'apprentissage avec une efficacité énergétique dix fois supérieure. C'est un gain énorme.

Économie circulaire et seconde vie

On en parle moins, mais le cycle de vie des équipements informatiques pose un vrai défi écologique. Un serveur se remplace typiquement tous les 3 à 5 ans, générant des montagnes de déchets électroniques. Les acteurs responsables développent maintenant des programmes de reconditionnement systématique : on teste les composants fonctionnels, on les certifie, puis on les revend à des utilisateurs moins exigeants en performance brute.

Certains data centers vont encore plus loin avec la conception modulaire. Les serveurs s'assemblent comme des briques Lego - on remplace uniquement les éléments obsolètes plutôt que tout le système. Économies à la clé, et impact environnemental réduit. Les métaux rares contenus dans les équipements font aussi l'objet de filières de recyclage spécialisées pour récupérer or, argent et terres rares.

Les tendances qui redessinent le secteur

L'hydrogène vert émerge comme alternative crédible pour les alimentations de secours. Traditionnellement, on utilisait des générateurs diesel pour garantir la continuité en cas de coupure. Mais leur empreinte carbone massive ne passe plus. Les piles à combustible hydrogène, alimentées par électrolyse renouvelable, offrent la même résilience sans polluer.

La récupération de chaleur atteint enfin sa maturité. À Stockholm, 10% du chauffage urbain provient déjà des data centers locaux. Paris, Lyon et Marseille développent des projets similaires, intégrant ces sources thermiques dans leurs réseaux de chaleur municipaux. On transforme un déchet énergétique en ressource précieuse.

Le quantum computing, longtemps cantonné aux labos, commence à s'intégrer dans les infrastructures commerciales. IBM et Google proposent maintenant un accès cloud à leurs processeurs quantiques. Ces machines, capables de résoudre certains problèmes des millions de fois plus vite que les ordinateurs classiques, nécessitent toutefois des conditions extrêmes : refroidissement proche du zéro absolu, isolation vibratoire totale. Leur déploiement à grande échelle représente le prochain défi d'ingénierie pour l'industrie.

Réglementations et Certifications

Bruxelles serre la vis sur l'efficacité énergétique. Le Code de Conduite Européen fixe désormais des seuils minimaux qui éliminent d'office les data centers les plus énergivores. Sans certification ISO 50001 ou un PUE correct, impossible de répondre aux appels d'offres publics ou d'accéder aux financements verts. Les règles du jeu ont changé.

Les opérateurs n'ont plus le choix : ils modernisent ou ils disparaissent. Les investissements dans le refroidissement liquide, l'IA pour optimiser la consommation ou la récupération de chaleur ne sont plus des options mais des nécessités. Paradoxalement, cette pression réglementaire améliore les marges : un data center moderne consomme 40% de moins qu'un site d'il y a dix ans, pour une puissance de calcul multipliée par cinq. Maintenant, un data center France de nouvelle génération affiche des PUE inférieurs à 1,2, contre 2,0 il y a une décennie - des progrès spectaculaires en optimisation énergétique.

L'avenir des data centers, c'est un peu comme un écosystème : infrastructures massives pour le stockage et le calcul intensif, micro-centres en périphérie pour la réactivité, installations spécialisées pour le quantum. Cette diversification reflète nos besoins numériques de plus en plus complexes.

Une chose est sûre : ces infrastructures numériques continueront de structurer notre monde connecté, mais seulement si elles réussissent leur mutation écologique. Le défi est énorme. Heureusement, les innovations foisonnent et l'industrie a compris qu'elle devait se réinventer ou disparaître. Cette prise de conscience ouvre une ère où technologie et durabilité peuvent enfin cohabiter - et c'est pas trop tôt.