DeepSeek V3 : Le Modèle IA Qui Se Prend Pour ChatGPT

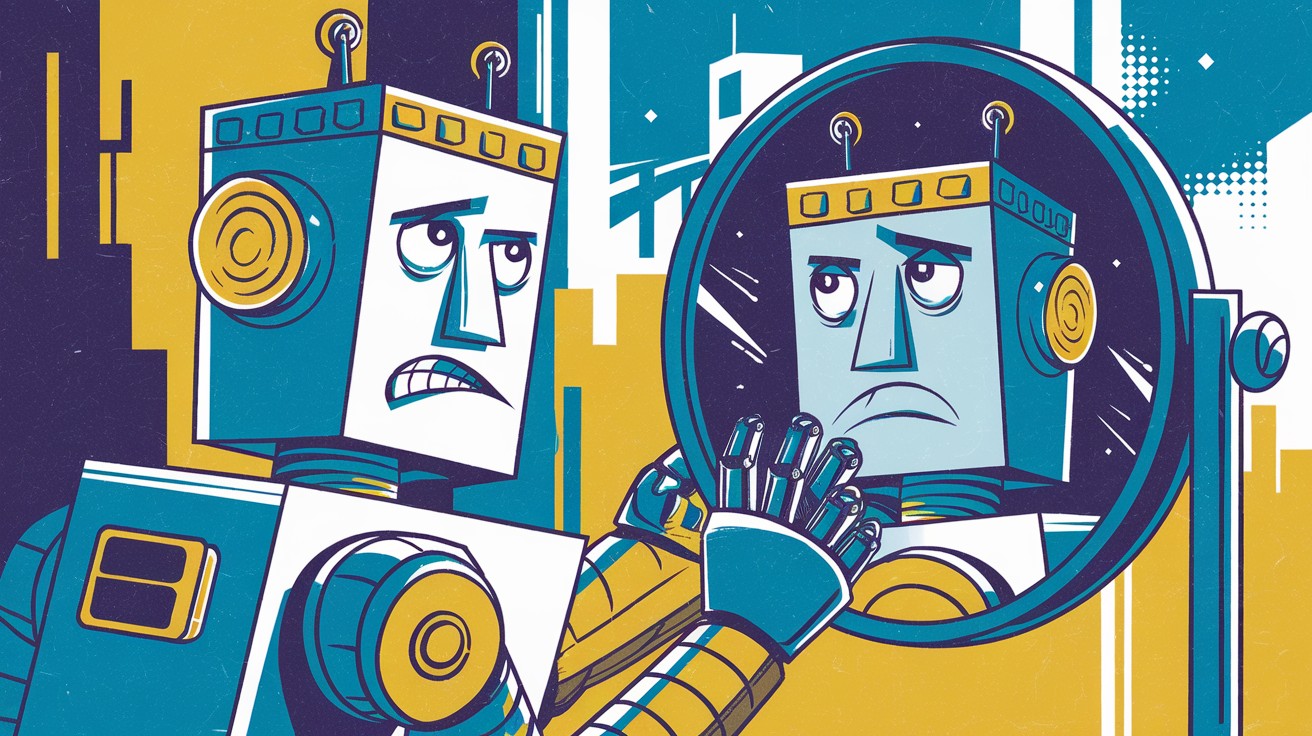

Quand un modèle d'intelligence artificielle se prend pour un autre, cela soulève de nombreuses questions. C'est exactement ce qui se passe avec DeepSeek V3, le dernier né du laboratoire chinois DeepSeek, qui semble convaincu d'être ChatGPT, le célèbre agent conversationnel d'OpenAI. Une situation qui met en lumière les enjeux de l'entraînement des IA sur des données issues d'autres modèles.

DeepSeek V3 : Un Modèle IA Qui a Du Mal à S'Identifier

Lancé en grande pompe cette semaine, DeepSeek V3 impressionne par ses performances sur de nombreuses tâches de traitement du langage naturel. Mais ce qui frappe surtout, c'est sa propension à se faire passer pour ChatGPT, insistant même sur le fait qu'il serait une version de GPT-4 sortie en juin 2023.

Un phénomène étonnant, que l'on peut reproduire assez facilement en interagissant avec le modèle. Sur 8 générations de réponses, il se présente 5 fois comme étant ChatGPT, contre seulement 3 fois comme DeepSeek V3. Des réponses qui en disent long sur la provenance de ses données d'entraînement...

Obviously, the model is seeing raw responses from ChatGPT at some point, but it's not clear where that is.

– Mike Cook, chercheur en IA au King's College de Londres

Un Entraînement Basé sur les Sorties de ChatGPT ?

L'hypothèse la plus probable est que DeepSeek V3 a été entraîné, au moins en partie, sur des données générées par GPT-4 via ChatGPT. Le modèle aurait ainsi mémorisé certaines sorties de GPT-4, qu'il régurgite maintenant telles quelles, y compris lorsqu'on lui demande de s'identifier.

Une pratique qui pose question, tant sur le plan éthique que technique. Comme l'explique Mike Cook, s'entraîner sur les sorties d'autres modèles peut fortement dégrader la qualité d'une IA, en la déconnectant petit à petit de la réalité :

Like taking a photocopy of a photocopy, we lose more and more information and connection to reality.

– Mike Cook, chercheur en IA au King's College de Londres

La Tentation de la Distillation des Connaissances

Si DeepSeek a effectivement entraîné son modèle sur des données issues de ChatGPT, cela ne serait pas si surprenant. La tentation est grande pour les développeurs d'IA d'utiliser la "distillation des connaissances", une technique consistant à entraîner un nouveau modèle sur les sorties d'un modèle existant.

L'avantage ? Des économies substantielles, puisqu'on n'a pas besoin de constituer soi-même un immense jeu de données. Mais le risque est d'amplifier les biais et défauts du modèle d'origine, comme semble le montrer le cas de DeepSeek V3.

If it is the case that DeepSeek carried out distillation partially using OpenAI models, it would not be surprising.

– Heidy Khlaaf, Chief AI Scientist à l'AI Now Institute

Vers une Prolifération des "Hallucinations" d'IA ?

Au-delà du cas DeepSeek V3, c'est toute la problématique de la contamination des données d'entraînement par des contenus générés par des IA qui est posée. Avec la multiplication des agents conversationnels et autres outils d'IA générative, il devient de plus en plus difficile de s'assurer de la "pureté" des données utilisées.

Un phénomène qui risque de favoriser la prolifération des "hallucinations", ces générations erronées ou biaisées dont sont coutumières les IA de grande envergure. Si les modèles s'entraînent les uns sur les autres sans recul critique, on peut craindre une dérive progressive, chaque génération d'IA amplifiant les défauts de la précédente.

Vers une Régulation de l'Entraînement des IA ?

Face à ces enjeux, la question d'une régulation de l'entraînement des modèles d'IA se pose de plus en plus. Certains, comme OpenAI, interdisent déjà dans leurs conditions d'utilisation d'exploiter les sorties de leurs modèles pour entraîner des IA concurrentes.

Mais au-delà des garde-fous contractuels, c'est peut-être vers une véritable régulation éthique et technique qu'il faudra se diriger. L'objectif : garantir la traçabilité et la qualité des données d'entraînement, pour éviter que les IA ne perdent pied dans un miroir aux alouettes de données générées par leurs propres congénères.

Le cas DeepSeek V3 a le mérite de mettre en lumière ces enjeux cruciaux pour le futur de l'IA. Espérons qu'il servira de prise de conscience pour l'industrie et les régulateurs, afin que les progrès spectaculaires de l'intelligence artificielle ces dernières années ne se fassent pas au prix d'une dérive progressive vers des modèles en perte de contact avec la réalité.

Comment (1)

🧠 Découvrez DeepSeek-V3 : L'IA Gratuite qui Révolutionne Votre Productivité ! 🚀

[…] les différentes manières de l’utiliser. N’hésitez pas à consulter des ressources comme ceci pour approfondir vos connaissances et découvrir des astuces. De plus, rester informé sur les […]