Les Limites des Évaluations de Sécurité pour les Modèles d’IA

Alors que la demande pour une intelligence artificielle plus sûre et responsable ne cesse de croître, un nouveau rapport vient pointer du doigt les limites des évaluations de sécurité actuelles. L'institut de recherche britannique Ada Lovelace Institute (ALI) a mené une étude approfondie révélant que les tests et benchmarks utilisés aujourd'hui pour jauger les risques des modèles génératifs d'IA présentent des lacunes significatives.

Des modèles génératifs sous haute surveillance

Capables de générer du texte, des images, de la musique ou encore des vidéos, les modèles d'IA génératifs suscitent un intérêt grandissant. Mais leur tendance à faire des erreurs et à se comporter de façon imprévisible inquiète. Du secteur public aux géants de la tech, de nombreux acteurs proposent de nouveaux benchmarks pour tester leur sécurité.

Scale AI a ainsi lancé fin 2022 un laboratoire dédié à évaluer l'alignement des modèles avec des guidelines de sûreté. En août 2024, le NIST américain et l'UK AI Safety Institute ont dévoilé des outils pour mesurer les risques. Mais ces efforts sont-ils suffisants ?

Une étude qui pointe les failles

Pour répondre à cette question, les chercheurs de l'ALI ont interrogé 16 experts issus du monde académique, de la société civile et d'entreprises développant des modèles génératifs. Ils ont également passé en revue les recherches récentes sur les évaluations de sécurité en IA.

Leur constat est sans appel : si les évaluations actuelles peuvent se révéler utiles, elles restent non-exhaustives, facilement manipulables et ne reflètent pas nécessairement les comportements des modèles en conditions réelles. Un désaccord profond règne par ailleurs dans l'industrie quant aux meilleures méthodes et taxonomies à adopter.

Qu'il s'agisse d'un smartphone, d'un médicament ou d'une voiture, nous nous attendons à ce que les produits que nous utilisons soient sûrs et fiables. Dans ces secteurs, les produits sont rigoureusement testés pour garantir leur sécurité avant d'être déployés.

Elliot Jones, chercheur senior à l'ALI et co-auteur du rapport

Benchmarks et red teaming en question

Parmi les problèmes soulevés, l'étude note qu'il est difficile d'extrapoler la performance d'un modèle à partir de résultats de benchmarks. Réussir un examen du barreau ne signifie pas qu'une IA sera capable de résoudre des défis juridiques plus ouverts.

La contamination des données, où les résultats surestiment les capacités d'un modèle entraîné sur les mêmes données que celles utilisées pour le tester, est également pointée du doigt. Les benchmarks sont souvent choisis par commodité plutôt que par pertinence.

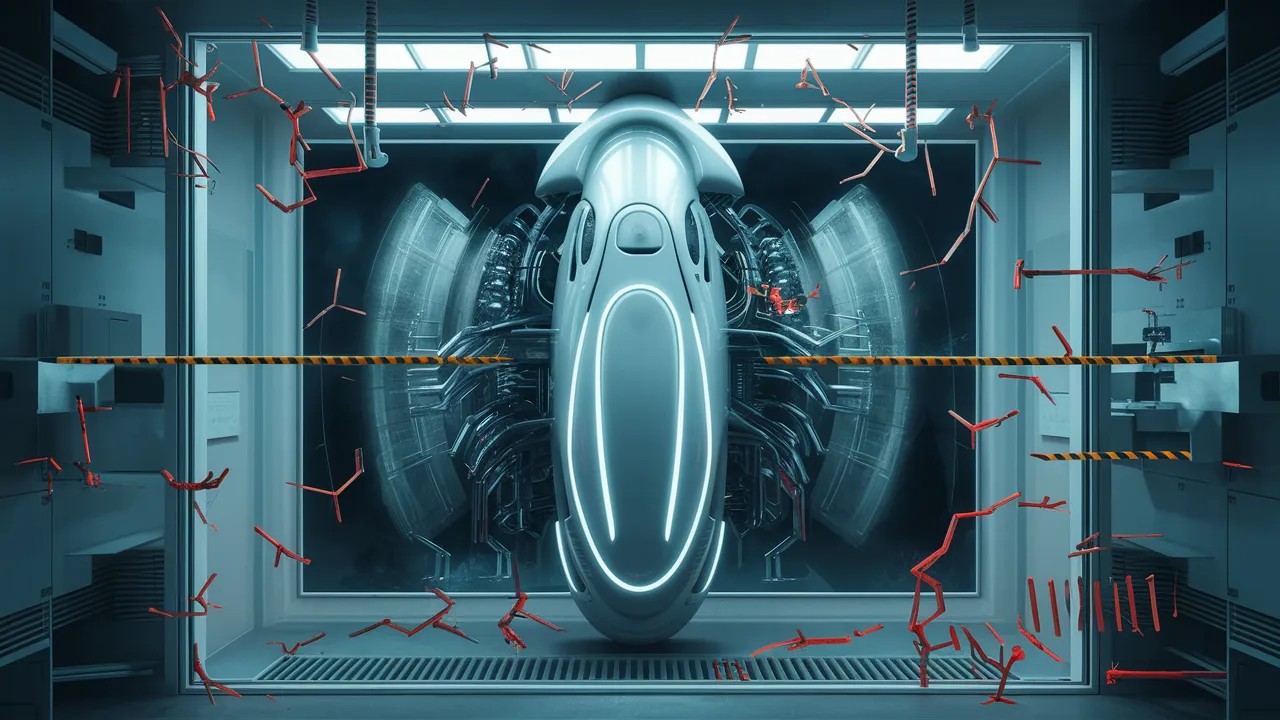

L'ALI s'inquiète aussi du manque de standards pour la pratique du « red teaming », qui consiste à attaquer un modèle pour identifier ses vulnérabilités. Trouver des experts qualifiés est difficile et le processus, chronophage et coûteux, reste hors de portée pour les petites structures.

Vers des solutions

Face à ces défis, les co-auteurs de l'étude estiment qu'une implication accrue des pouvoirs publics est nécessaire. Les régulateurs doivent clarifier leurs attentes et la communauté des évaluateurs doit être transparente sur les limites actuelles.

- Mandater une plus grande participation du public dans le développement des évaluations

- Soutenir un écosystème de tests tiers avec un accès régulier aux modèles et données

- Développer des évaluations « contextuelles » allant au-delà de la réponse à une requête

Mais il n'existera sans doute jamais de garantie absolue qu'un modèle est sûr. Déterminer la sécurité d'une IA nécessite de comprendre les contextes d'utilisation, les utilisateurs et la robustesse des garde-fous en place. Les évaluations peuvent identifier des risques potentiels, pas prouver l'absence de danger.

À mesure que les modèles génératifs se répandent, bâtir un cadre d'évaluation rigoureux, transparent et adapté au monde réel s'avère plus crucial que jamais. Un défi de taille pour l'écosystème de l'IA, mais aussi une opportunité d'innover de façon responsable. L'avenir nous dira si le pari est réussi.