L’informatique quantique franchit un cap crucial

L'ordinateur quantique est-il sur le point de révolutionner des domaines comme la chimie, les nouveaux matériaux ou la médecine ? Les récents progrès en matière de correction d'erreurs quantiques suggèrent que oui. En décembre 2024, des chercheurs de Google Quantum AI ont franchi un cap crucial, prouvant expérimentalement l'efficacité de techniques théorisées il y a près de 30 ans pour fiabiliser le calcul quantique.

Des débuts prometteurs mais des machines encore limitées

Retour en arrière. En 2018, le physicien John Preskill émet l'hypothèse que les premières puces quantiques, bien qu'imparfaites, pourraient déjà surpasser les ordinateurs classiques sur certains problèmes. C'est l'avènement des machines quantiques dites "bruitées" ou Nisq (noisy intermediate-scale quantum). Leur atout ? Tolérer un taux d'erreur élevé sur les qubits, ces bits quantiques sujets à la décohérence.

Problème : malgré les progrès, le taux d'erreur demeure trop important pour traiter des applications concrètes. Les algorithmes Nisq peinent à convaincre. Il faut donc changer d'approche pour aller plus loin.

Cap sur la correction d'erreurs quantiques

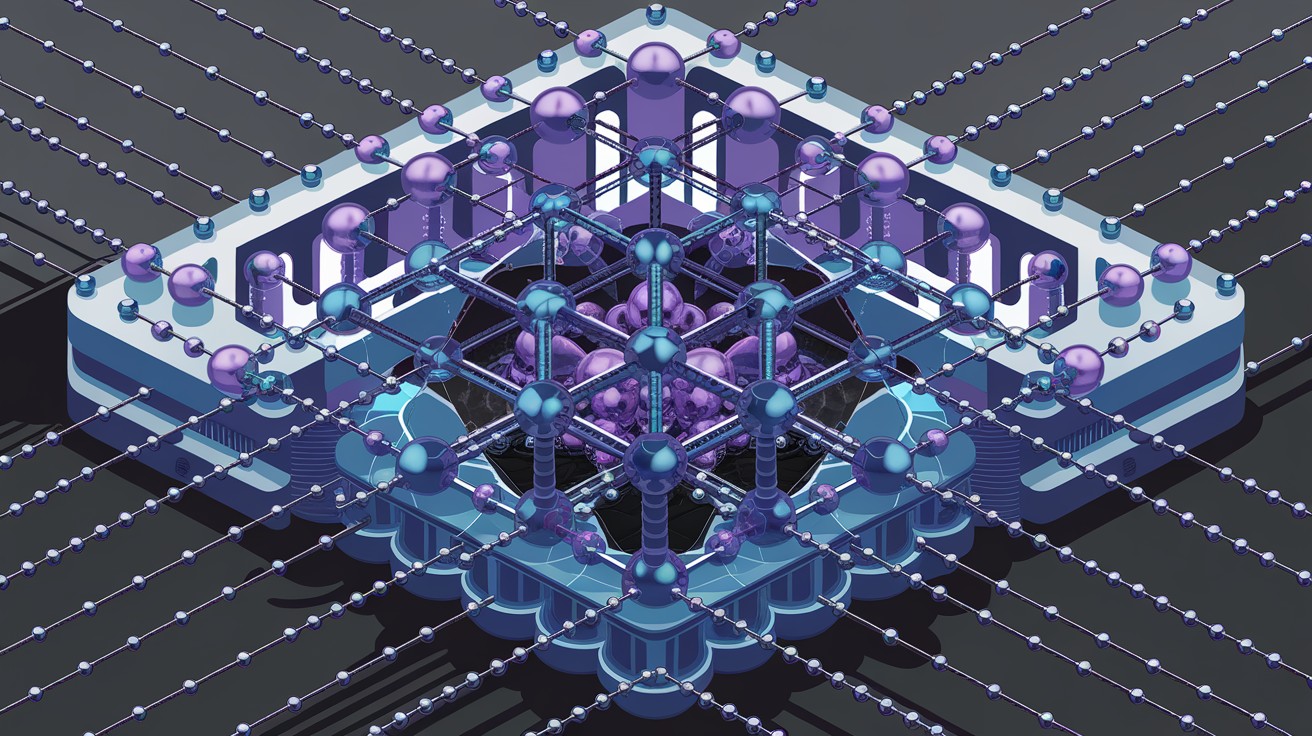

La solution ? Encoder l'information sur plusieurs qubits physiques pour former des qubits logiques plus robustes. Si une erreur survient, elle peut être détectée et corrigée grâce aux qubits voisins. C'est le principe de la correction d'erreurs quantiques, au cœur du calcul tolérant aux fautes (FTQC).

Dans le domaine de la correction d'erreurs quantiques, on constate une réelle accélération depuis quatre à cinq ans.

Anthony Leverrier, chercheur à l'Inria

Et les acteurs du quantique l'ont bien compris. Selon une étude de la deeptech Riverlane, plus de la moitié des startups interrogées ont adopté une stratégie de correction d'erreurs. L'enjeu : atteindre un taux d'erreur suffisamment bas pour exécuter des algorithmes quantiques longs et complexes.

Un nouveau jalon franchi par Google

C'est chose faite pour Google, qui a réussi à réduire le taux d'erreur de son qubit logique en deçà de celui d'une porte à deux qubits physiques. Une première, rendue possible par sa nouvelle puce Willow, qui ouvre la voie à un véritable avantage quantique. Mais il reste du chemin :

- 1500 qubits physiques seraient nécessaires pour un qubit logique fiable.

- Les machines actuelles ne dépassent pas la centaine de qubits.

- D'autres techniques de correction, moins coûteuses, sont à l'étude.

Quid des technologies habilitantes ?

Cryogénie, électronique de contrôle... Les défis d'ingénierie pour opérer ces futurs processeurs quantiques géants sont immenses. Des projets comme Cryonext planchent sur une cryogénie plus efficace et évolutive. Côté électronique, la conception de puces cryogéniques opérant à 4 K est une piste prometteuse.

La simulation analogique, une autre voie d'avenir

Enfin, n'oublions pas une autre approche pertinente : la simulation analogique. Des acteurs comme la deeptech française Pasqal misent sur des processeurs à base d'atomes neutres pour reproduire le comportement de systèmes complexes, comme des molécules. L'idée ? Atteindre un avantage quantique avec seulement quelques centaines de qubits de haute qualité.

En somme, malgré les immenses défis qui demeurent, ces avancées en calcul quantique tolérant aux fautes et en simulation ouvrent des perspectives enthousiasmantes. Rendez-vous dans quelques années pour les premières applications quantiques révolutionnaires !