Nvidia Lance l’Architecture Rubin Révolutionnaire

Imaginez un monde où les modèles d’intelligence artificielle ne se contentent plus de répondre à vos questions, mais anticipent vos besoins sur plusieurs jours, gèrent des tâches complexes en autonomie et apprennent en continu sans jamais oublier le contexte. Cette vision, encore futuriste pour beaucoup, se rapproche dangereusement de la réalité grâce à une annonce faite au CES 2026. Nvidia, le géant incontesté des semi-conducteurs pour l’IA, vient de lever le voile sur sa nouvelle architecture baptisée Rubin. Un nom qui résonne déjà comme le symbole d’une nouvelle ère computationnelle.

Rubin : quand Nvidia redéfinit la puissance brute pour l’IA

Présentée par Jensen Huang en personne sur la scène de Las Vegas, l’architecture Rubin n’est pas simplement une nouvelle génération de GPU. C’est un système complet pensé pour répondre à l’explosion des besoins en calcul des modèles d’IA modernes. Alors que les puces Blackwell, lancées il y a à peine un an et demi, semblaient déjà repousser les limites, Rubin les pulvérise avec des gains de performance impressionnants.

Selon les premières données communiquées par Nvidia, Rubin offre jusqu’à 3,5 fois plus de vitesse sur les tâches d’entraînement de modèles et atteint 5 fois plus de performance en inférence par rapport à Blackwell. Mieux encore : la consommation énergétique est optimisée au point de délivrer jusqu’à huit fois plus de calcul d’inférence par watt. Dans un contexte où les data centers engloutissent des quantités colossales d’électricité, cette avancée représente un argument de poids pour les géants du cloud.

Un nom rendu hommage à une astronome visionnaire

Le choix du nom n’est pas anodin. Vera Rubin, astronome américaine décédée en 2016, est célèbre pour avoir fourni des preuves observationnelles majeures de l’existence de la matière noire. En nommant son architecture en son honneur, Nvidia rend hommage à une scientifique qui a su voir l’invisible. Une belle métaphore pour une technologie capable de faire émerger des capacités jusque-là inimaginables dans les systèmes d’IA.

« Vera Rubin est conçue pour répondre à ce défi fondamental : la quantité de calcul nécessaire pour l’IA explose. »

– Jensen Huang, PDG de Nvidia

Cette phrase prononcée lors de la keynote résume parfaitement l’ambition derrière Rubin : ne plus seulement suivre la courbe exponentielle des besoins en calcul, mais la devancer largement.

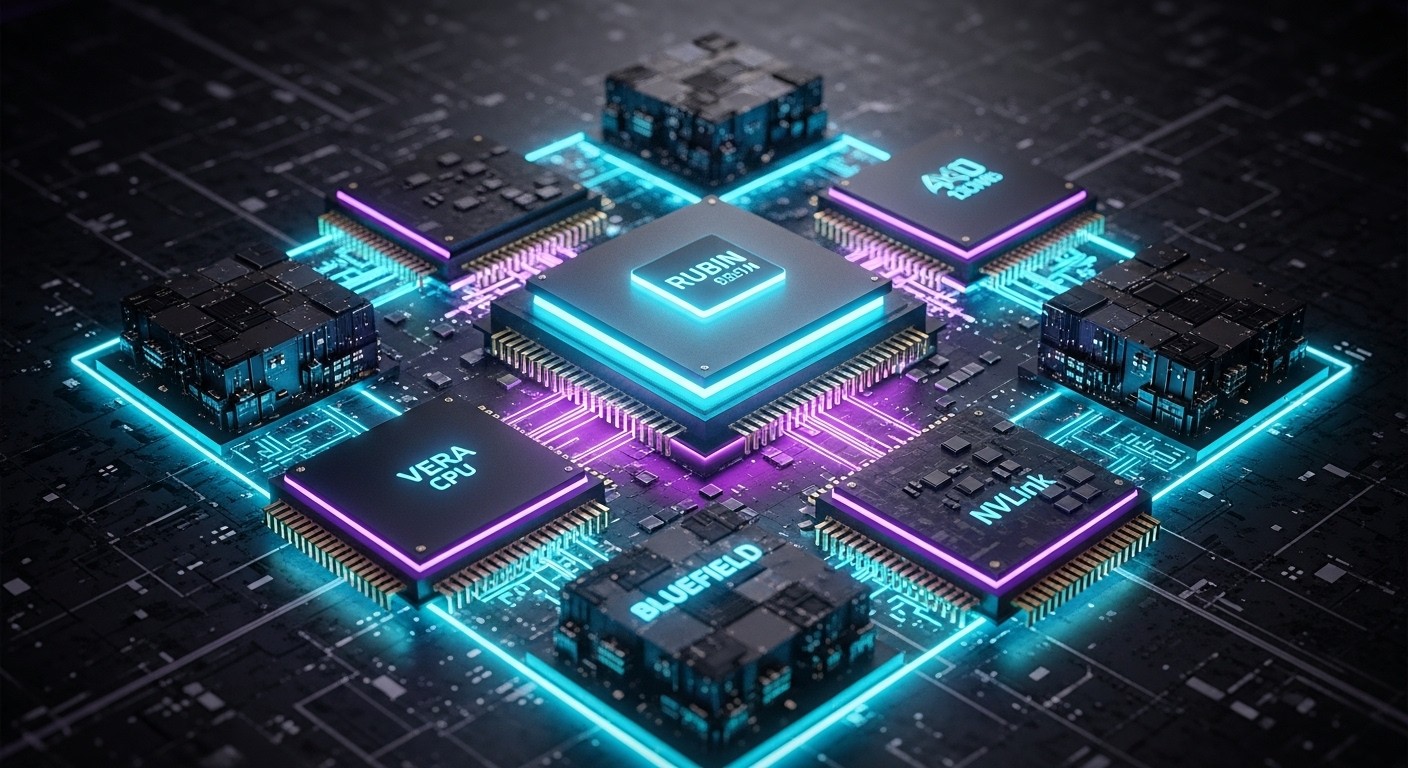

Six composants interconnectés pour une architecture modulaire

Contrairement à une simple puce GPU plus performante, Rubin est un véritable écosystème composé de six éléments distincts travaillant en parfaite synergie :

- Le GPU Rubin, cœur battant de la plateforme

- La nouvelle Vera CPU, optimisée pour le raisonnement agentique

- Bluefield nouvelle génération pour le stockage et le réseau

- NVLink ultra-rapide repensé pour des interconnexions massives

- Un nouveau niveau de stockage externe dédié au KV cache

- Améliorations logicielles pour l’orchestration globale

Cette modularité permet de s’adapter aux différents goulots d’étranglement qui apparaissent lorsque l’on passe des modèles de quelques centaines de milliards de paramètres à des systèmes multi-trillions.

La révolution du KV cache externe : la clé des agents autonomes

L’une des innovations les plus commentées concerne la gestion du KV cache (Key-Value cache), cette mémoire qui permet aux grands modèles de conserver le contexte sur de très longues conversations ou tâches. Jusqu’ici, ce cache saturait rapidement la mémoire HBM ultra-rapide des GPU.

Nvidia introduit désormais un niveau de stockage intermédiaire externe spécifiquement conçu pour scaler massivement cette mémoire critique. Dion Harris, senior director chez Nvidia, expliquait :

« Les nouveaux workflows comme l’IA agentique ou les tâches à long terme exercent une pression énorme sur le KV cache. Nous avons donc créé un nouveau tier de stockage externe qui permet de scaler le pool de mémoire de manière beaucoup plus efficace. »

– Dion Harris, Nvidia

Concrètement, cela signifie que les systèmes pourront conserver des historiques de plusieurs millions de tokens sans devoir constamment recomposer le contexte, ouvrant la voie à des agents IA capables de travailler sur des projets durant des semaines.

Des partenaires prestigieux déjà alignés

Les annonces de ce type sont souvent suivies d’une longue liste de partenaires. Rubin ne déroge pas à la règle. Parmi les premiers adopteurs confirmés :

- Anthropic (maison de Claude)

- OpenAI (ChatGPT, o1, etc.)

- Amazon Web Services

- Hewlett Packard Enterprise pour le superordinateur Blue Lion

- Lawrence Berkeley National Lab avec le futur superordinateur Doudna

Cette adoption rapide par les acteurs les plus avancés de l’IA montre que Rubin répond à un besoin urgent et non à une simple mise à jour incrémentale.

50 petaflops et une bataille énergétique sans précédent

Les chiffres bruts impressionnent : jusqu’à 50 petaflops en inférence sur certaines configurations. Mais au-delà de la puissance brute, c’est surtout l’efficacité énergétique qui pourrait faire la différence dans les années à venir. Alors que les hyperscalers cherchent désespérément des gigawatts supplémentaires pour alimenter leurs clusters, une multiplication par huit du calcul par watt consommé représente une bouffée d’oxygène considérable.

Jensen Huang lui-même estimait en octobre 2025 que 3 à 4 trillions de dollars seraient investis dans les infrastructures IA au cours des cinq prochaines années. Avec Rubin, Nvidia se positionne clairement pour capter une part très significative de cette manne financière.

Vers une IA agentique réellement autonome ?

Si Rubin impressionne sur le plan technique, c’est surtout son orientation vers l’IA agentique qui suscite le plus d’enthousiasme. Les modèles actuels excellent dans le traitement de requêtes ponctuelles. Les agents, eux, doivent raisonner, planifier, utiliser des outils externes, se souvenir longtemps et corriger leurs erreurs sur de longues périodes.

La combinaison d’une Vera CPU dédiée au raisonnement, d’un KV cache scalable à l’infini et d’une interconnexion NVLink ultra-rapide pourrait enfin permettre de passer du stade de la preuve de concept à celui du déploiement industriel à grande échelle.

Les experts s’accordent à dire que 2026-2027 pourrait marquer le véritable tournant vers des systèmes IA capables de travailler de manière autonome sur des tâches complexes pendant des jours, voire des semaines. Rubin semble avoir été conçu précisément pour accompagner cette transition.

Un cycle d’innovation qui ne faiblit pas

Depuis l’arrivée de l’architecture Ampere en 2020, Nvidia maintient un rythme effréné : Hopper, Lovelace, Blackwell… et maintenant Rubin. Chaque génération arrive environ tous les 18 à 24 mois avec des bonds de performance de 3x à 5x. Cette cadence infernale maintient une avance technologique considérable sur la concurrence (AMD, Intel, startups chinoises, etc.) tout en créant une forme de dépendance chez les acteurs de l’IA.

Mais ce rythme pose aussi des questions : jusqu’où ira cette course à la puissance brute ? Quand les gains marginaux deviendront-ils trop faibles face aux coûts énergétiques et financiers ? Rubin semble repousser cette limite de plusieurs années encore.

En attendant, les data centers du monde entier se préparent déjà à accueillir les premières vagues de serveurs Rubin dès la seconde moitié de 2026. Une page supplémentaire de la révolution IA est en train de s’écrire, et Nvidia tient fermement le stylo.